Antimatière

Au seuil de l’antimonde

Grande première au Cern de Genève : les physiciens viennent d’assembler des antiélectrons et des antiprotons pour former les neuf premiers anti-atomes d’hydrogène. L’aboutissement d’une longue quête. Et l’amorce de la réponse à une question clé : l’antimonde respecte-t-il les mêmes lois que notre monde ? On savait qu’au moment du big bang, il existait dans l’Univers autant de matières que d’antimatière. Mais justement la nature a choisi la première.

Pourquoi ? Comment ? L’expérience du Cern va permettre de mieux le comprendre. Du coup, on se prend à imaginer l’impossible : ira-t-on demain visiter les étoiles, à bord de vaisseaux propulsés par l’antimatière ? Ce « carburant » très spécial ne manque pas d’arguments. Et fait déjà rêver quelques ingénieurs…

I – Ils ont créé des anti-atomes

On connaissait déjà les antiparticules. Les physiciens viennent d’assembler des anti-électrons et des anti-protons pour former les premiers anti-atomes d’hydrogène. L’aboutissement d’une longue quête. Et une étape décisive dans la compréhension de l’Univers.

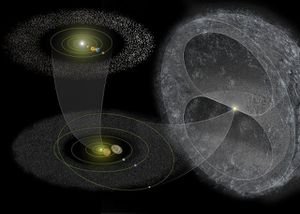

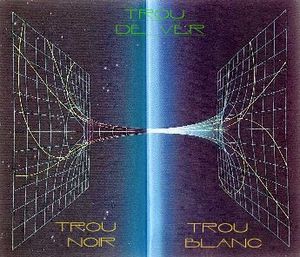

Neuf anti-atomes ont vécu, l’espace de quelques milliardièmes de seconde, à l’intérieur d’un accélérateur du CERN (le Centre européen de recherche sur la physique des particules). Ces anti-atomes d’hydrogène, les premiers créés par l’homme, sont-ils les seuls de l’Univers ? Ou bien ont-ils, quelque part, des frères naturels que nous ignorons, au sein d’un anti-monde, symétrique du nôtre, qui n’a jamais laissé entrevoir le moindre signe de son existence ? Mystère. En un sens, le plus extraordinaire n’est pas qu’on ait réussi à fabriquer de l’antimatière, c’est bien qu’il n’y en ait pas davantage !

Première apparition dans une équation en 1931

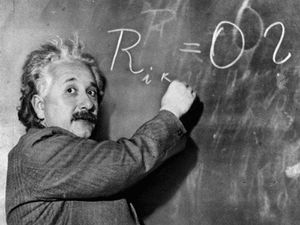

Car les lois de la physique sont symétriques. Et l’on voit mal pourquoi elles auraient façonné un monde unilatéral uniquement composé de matière. L’antimatière a d’abord été une théorie avant d’être matérialisée en laboratoire. C’est dans une équation qu’elle a fait sa première apparition, en 1931. En ces décennies 20 et 30, qui furent l’âge d’or de la physique contemporaine, chaque année apportait sa moisson de nouvelles particules et de découvertes « révolutionnaires » sur la structure de l’atome. La toute nouvelle théorie quantique révélait le comportement étrange et paradoxal de ce monde microscopique.

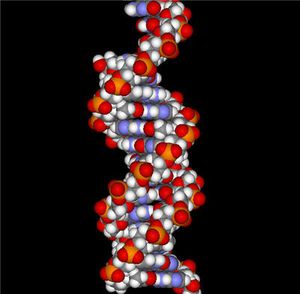

Un jeune mathématicien britannique, Paul Dirac (1902-1984), cherchait alors à décrire mathématiquement le comportement des électrons, en conciliant les deux grands principes de la physique moderne : la théorie quantique et la relativité restreinte d’Einstein (qui s’applique aux objets dont la vitesse est proche de celle de la lumière). Dirac voulait en fait généraliser l’équation quantique de l’électron, de sorte qu’elle s’applique aussi à un électron très rapide, « relativiste » comme disent les physiciens. Il trouva effectivement une magnifique équation, à la fois quantique et relativiste, qui, de surcroît, faisait apparaître spontanément, comme par miracle, des propriétés de l’électron qu’on avait mesurées par l’expérience.

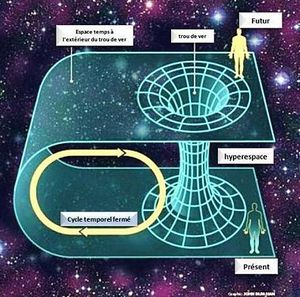

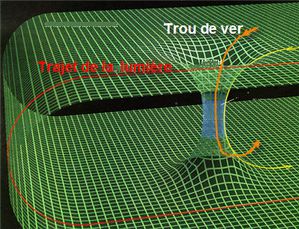

Pourtant, cette équation souffrait d’une incohérence apparente : elle admettait deux solutions, l’une décrivait un électron « normal », l’autre semblait correspondre à une particule d’énergie négative. Ce qui est rigoureusement impossible, car, si l’énergie était négative, la matière, qui tend à avoir l’état d’énergie le plus bas possible, s’effondrerait sur elle-même. De plus, un électron d’énergie négative serait affublé d’une fréquence négative (en physique quantique, toute particule est associée à une onde, dont la fréquence est proportionnelle à l’énergie de la particule. Ce qui revient à dire qu’il remonterait le temps ! Or, la relativité repose sur un principe intangible : la cause doit toujours précéder l’effet. Dans ce cadre, le renversement du temps, qui implique que l’effet précède la cause (le film passant à l’envers), est inacceptable.

Malgré ces apparentes contradictions, Dirac ne voulait pas abandonner son équation, par ailleurs si satisfaisante. Aussi proposa-t-il une autre interprétation, qui retournait la situation. Une particule d’énergie négative remontant le temps est mathématiquement équivalente à une particule d’énergie positive parcourant le temps dans le bon sens, qui aurait la même masse mais une charge électrique opposée : un électron de charge positive et non plus négative, autrement dit un anti-électron.

Moins d’un an plus tard, en étudiant le rayonnement cosmique, l’Américain Carl Anderson – qui ignorait tout de l’audacieuse hypothèse de Dirac – observe sur un cliché de détecteur la trace d’une particule inconnue. Sa courbure, dans le champ magnétique de la chambre, désignait une particule positive, mais de masse égale à celle d’un électron : c’était l’anti-électron (également appelé positron, ou encore positon) prédit par Dirac ! En fait, cette particule étrange était issue d’un rayon cosmique qui, en entrant en contact avec les atomes de l’atmosphère, avait « matérialisé » une partie de son énergie en une paire électron-positron. En effet, les rares antiparticules naturelles qu’on observe sur Terre sont des produits « secondaires » des particules cosmiques.

Toute particule possède une antiparticule

Plus tard, généralisant son équation, Dirac montrera que, dans le cadre d’une théorie à la fois quantique et relativiste, la matière doit nécessairement posséder une image symétrique. Autrement dit, toute particule admet une antiparticule dont toutes les charges sont opposées. Les charges et pas seulement la charge électrique ! Si cette dernière est bien connue, les autres « charges » sont des propriétés purement quantiques (agissant au niveau microscopique), qui déterminent l’identité de chaque particule, mais n’ont pas de traduction dans le monde qui nous est familier (macroscopique).

Ainsi, de même que la charge électrique définit la façon dont la particule réagit vis-à-vis de la force électromagnétique, les autres charges (appelées isospin, charge de couleur, hypercharge…) caractérisent la particule vis-à-vis d’autres interactions, cantonnées au niveau microscopique. Ainsi, bien que le neutron soit électriquement neutre, il existe un antineutron dont le moment magnétique est inversé par rapport à celui du neutron. En revanche, le photon n’a pas d’antiparticule, ou, plus exactement, il est lui-même sa propre antiparticule, car toutes ses charges sont nulles. Jusqu’à présent, la règle s’est toujours vérifiée : toute particule connue possède bien une antiparticule.

Des milliards de collisions en trois semaines

Depuis la découverte de l’antiproton, en 1955, l’antimatière s’est banalisée, puisque les physiciens ont appris à la fabriquer (par des chocs de particules), à la récupérer et à l’utiliser sous forme de faisceaux pour provoquer de nouvelles collisions. Plusieurs collisionneurs électrons-positrons ont ainsi été construits à travers le monde, le plus puissant étant le LEP du CERN. Car les antiparticules ont un grand avantage pratique : elles permettent de réduire de moitié les systèmes d’accélération électrique et de guidage magnétique des collisionneurs. En effet, les électrons et les positrons ayant des charges électriques opposées, un unique champ électrique et un unique champ magnétique imposent aux deux faisceaux des trajectoires rigoureusement inversées.

Poursuivant un objectif analogue, le physicien néerlandais Simon Van der Meer trouva le moyen, en 1975, de réaliser des faisceaux denses d’antiprotons, ce qui permit de transformer un cyclotron du CERN en collisionneur protons-antiprotons. C’est dans ce collisionneur qu’une équipe internationale dirigée par Carlo Rubbia découvrit, en 1983, les bosons W et Z (particules qui véhiculent la force faible). L’année suivante, cet exploit expérimental valut au physicien italien un prix Nobel partagé avec Van der Meer.

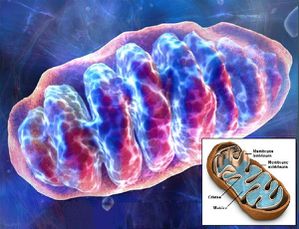

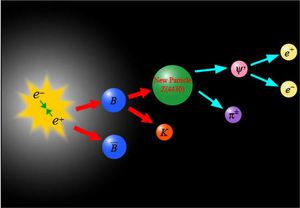

La production de ces antiparticules « libres » étant maîtrisée, il restait à découvrir, ou à fabriquer, des antiatomes, c’est-à-dire de l’antimatière au vrai sens du terme. L’exploit vient d’être accompli, au CERN, par vingt-trois physiciens allemands et italiens réunis, sous la houlette de Walter Oelert, autour de l’accélérateur LEAR (Low Energy Antiproton Ring). Des antiprotons ont rencontré des antiélectrons, pour donner naissance à neuf antiatomes d’hydrogène. Le principe est très simple, l’expérience plus délicate.

Dans le cyclotron LEAR, un carré aux coins arrondis de 20 m de côté, un milliard d’antiprotons effectuent trois millions de tours par seconde. On injecte sur leur trajet un fin jet de gaz xénon : à chaque tour, quelques antiprotons rencontrent des noyaux de xénon, et il arrive – très rarement – qu’une partie de l’énergie du choc se matérialise en paire électron-positron.

Quand, de plus (par bonheur…), la différence entre la vitesse du positron et celle de l’antiproton est suffisamment faible, ces deux antiparticules parviennent à s’unir pour former – enfin – un antiatome d’hydrogène. Celui-ci poursuit sa route en ligne droite sans être dévié par les aimants, car, tout comme un atome ordinaire, il est électriquement neutre. Il aboutit, 10 mètres et 40 milliardièmes de seconde plus loin, sur une plaque de silicium. La rencontre avec la matière lui est fatale : il s’annihile instantanément.

C’est cette double désintégration d’un antiélectron et d’un antiproton, mesurée par deux détecteurs, qui prouve la création d’un antiatome. Les milliards de collisions enregistrées en trois semaines d’expérience ont donné naissance à neuf antiatomes d’hydrogène. C’est ce qu’affirment Oelert et son équipe, après avoir minutieusement vérifié, pendant trois mois, les calculs et les enregistrements. Même si, en raison de l’importance du bruit de fond, certains de leurs collègues doutent de la valeur du résultat…

Une anti-pomme tomberait-elle de son anti-arbre ?

Mais on ne crée pas des antiatomes pour le plaisir de relever un défi. Ou pas seulement. L’objectif réel, primordial, est de vérifier si la symétrie la plus fondamentale de toute la physique, dite CPT, est toujours respectée « Pourquoi le monde a vaincu l’antimonde ». Il s’agit de répondre à des questions de fond : les antiatomes se comportent-ils bien comme des atomes vis-à-vis de la gravitation ? Une anti-pomme tomberait-elle de son anti-arbre ? Pour le vérifier, neuf antiatomes d’hydrogène éphémères ne suffisent pas, on aurait besoin de milliards d’antiatomes stables.

En fait, les espoirs se tournent vers une autre voie, explorée en particulier par Gerald Gabrielse, de l’université Harvard, la création d’antimatière « froide ». Ainsi, le physicien américain parvient déjà à conserver des antiprotons à – 269° C pendant des semaines, dans un « piège » magnétique. On sait également mettre des positrons en « bouteille ». Reste le plus difficile : verser le contenu de la bouteille dans l’autre !

II – Pourquoi le monde a vaincu l’antimonde

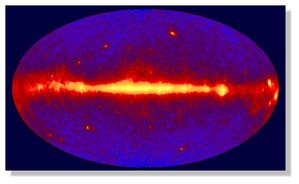

Au départ, il y a le big bang. A ce moment, il existe dans l’Univers autant de matière que d’antimatière. La nature choisira la première. Pourquoi ? Comment ? La science commence à le comprendre…

S’il est une énigme qui a longtemps hanté le sommeil des astrophysiciens, c’est bien celle de l’antimatière. Son absence les dérangeait : ils avaient beau la chercher dans les recoins les plus éloignés de l’univers visible, ils n’arrivaient pas à mettre la main dessus. Or, cette absence mettait à mal les théories les plus cohérentes sur l’origine de l’Univers. Jusqu’à récemment, l’astrophysique ne parvenait pas à expliquer qu’il puisse y avoir de la matière sans qu’il existe une quantité égale d’antimatière…

Mais, grâce à une intuition géniale du théoricien soviétique de l’antimatière Andreï Sakharov (ou plutôt du théoricien antisoviétique de la matière), les scientifiques sont aujourd’hui en passe de résoudre l’énigme. La création, au CERN, du premier atome d’anti-hydrogène va confirmer – ils l’espèrent – leurs hypothèses. Essayons de comprendre pourquoi.

Quoi de plus naturel, lorsqu’on croque une pomme, de se dire que plus on en mange, moins on en a, autrement dit qu’on réduit la pomme d’une quantité égale à celle du morceau qu’on a croqué. Cette expérience a beau être intuitive, elle n’en porte pas moins un nom savant : le principe de symétrie. Celui-ci veut que ce qui disparaît ici – dans la pomme – apparaisse là – dans la bouche -, de sorte que se conserve toujours la même quantité de matière. Pourtant, l’astrophysicien se méfie de ce principe, et il n’a pas tort. Car ce qui fait que nous existons, c’est justement la violation de la symétrie. Bref, l’Univers doit son existence à un drôle de principe qui veut qu’une pomme qu’on croque demeure toujours entière.

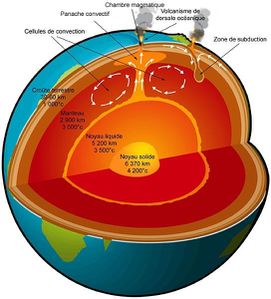

Un exemple : selon l’hypothèse la plus vraisemblable aujourd’hui, l’Univers a eu un commencement, c’est la théorie du big bang. Bien qu’il soit impossible de parler d’un « avant big bang » - car celui-ci marque le début de l’espace et du temps -, on s’accorde à dire qu’au moment du big bang il y a eu création de matière à partir de rien ou plus exactement à partir du vide ! Heureusement, la physique quantique, celle qui s’occupe de l’infiniment petit, a réussi à expliquer ce phénomène sans porter atteinte au principe de symétrie, grâce au paradigme matière-antimatière.

En effet, s’il se crée dans le vide une particule de matière, il faut que simultanément se crée son antiparticule : le volume de « vide » dans la pomme doit être le même que le volume de pomme qu’on a croqué. Le principe de symétrie est sauvé. Mais comment le vide peut-il engendrer quelque chose ? Suivant la physique quantique, quelle que soit la situation, une probabilité constamment nulle n’existe pas. Ce qui veut dire qu’il ne peut y avoir de vide total tout le temps.

Le vide quantique est donc non pas le néant mais un lieu où il n’y a pas de particules réelles. Il est le siège de fluctuations d’énergie. Reprenons le scénario classique du big bang : c’est d’une immense fluctuation quantique du vide qu’est né un intense rayonnement (les photons), dégageant une chaleur de l’ordre de 1032 degrés ! L’énergie de fluctuation s’est changée en énergie rayonnante.

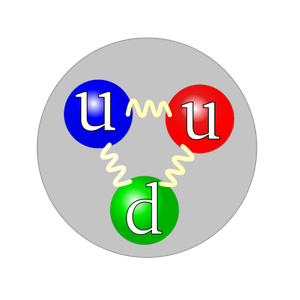

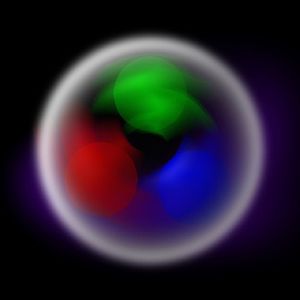

Comme l’a expliqué Einstein, au début du siècle, l’énergie peut se transformer en matière et vice-versa (la fameuse équation E = mc²). Voilà donc des milliards de photons super-énergétiques qui se muent en particules et en antiparticules antagonistes (surtout des quarks, mais aussi des électrons… avec leurs antiparticules) suivant la théorie élaborée par Dirac en 1931. Elles s’annihilent à nouveau pour donner des photons – car lorsqu’une particule rencontre son antiparticule, elles se désintègrent mutuellement en produisant un feu d’artifice de lumière. Pendant ce temps, la température chute, du fait de l’expansion de l’Univers : ce magma de rayonnement, matière et antimatière, se répand dans toutes les directions.

Dans les années 60, les physiciens pensaient que, puisque au début il y a du vide, il faut que l’union de toutes les particules et antiparticules créées redonne du vide, toujours pour respecter le principe de symétrie. Bref, à ce moment de l’histoire de l’Univers, on trouve autant d’antiparticules que de particules. La suite de l’histoire était la suivante : plus la température baisse, plus les photons ont du mal à se transformer en couples de particules antagonistes puisqu’ils perdent de l’énergie. L’expansion rend plus rare la rencontre – donc l’annihilation – des particules et de leurs antiparticules. Selon cette hypothèse, simple, la séparation de la matière et de l’antimatière expliquerait l’existence de l’Univers.

On aurait pu s’en tenir à ce scénario à condition de « retrouver » l’antimatière censée être née avec la matière. Où est-elle passée ? Telle était la question. Hélas, les observations ne fournirent pas la réponse : notre galaxie et les galaxies environnantes sont constituées de matière pure !

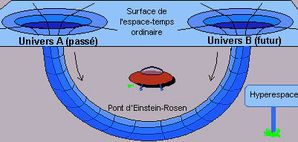

L’astrophysicien suédois Hannes Alfvén, prix Nobel de physique 1970, émit l’hypothèse légèrement différente : l’Univers est bien constitué de matière et d’antimatière en quantités égales, mais isolées, car se repoussant comme l’huile et l’eau. Il existerait alors, quelque part dans l’Univers, une « frontière d’annihilation » trop éloignée pour que nous puissions l’observer.

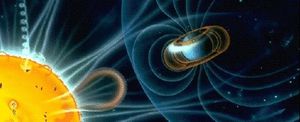

Comment justifier une telle hypothèse ? A priori, les particules de matière et d’antimatière s’attirent. On observe depuis longtemps ce phénomène dans les accélérateurs de particules. Mais cette attraction est surtout de nature électromagnétique, car leurs charges électriques sont opposées. Cependant, on ne sait quel rôle joue dans cette attraction la force de gravité, celle qui est en jeu dans les grandes structures de l’Univers. Les lois de la gravitation universelle – énoncées par Newton et élargies par Einstein dans la relativité générale – veulent que deux corps solides s’attirent d’autant plus intensément que leur densité est grande. C’est notamment la raison pour laquelle nous restons les pieds sur Terre.

La Lune, elle, est six fois moins dense que la Terre. Son attraction est donc six fois moins importante : les sauts de « sept lieues » des astronautes américains d’Apollo 11 sur la surface de la Lune l’illustrèrent de belle façon. Toujours est-il qu’on ne sait pas si cette loi d’attraction est valable pour l’antimatière. En effet, entre les particules et les antiparticules obtenues jusqu’à présent dans les accélérateurs, l’attraction électromagnétique masquait l’attraction gravitationnelle (moins forte à cette échelle).

L’obtention d’atomes d’anti-hydrogène (de charge électrique nulle) au CERN pourrait permettre d’observer l’interaction gravitationnelle avec des atomes d’hydrogène. Si la matière et l’antimatière se repoussent gravitationnellement, alors l’hypothèse d’un monde séparé d’un antimonde par une frontière est plausible. Mais l’existence d’une telle « répulsion gravitationnelle » est fortement improbable. Comme nous l’indique le physicien Alain Bouquet, du laboratoire de physique corpusculaire du Collège de France, « imaginer un effet répulsif de nature gravitationnelle contredirait l’une des hypothèses de base de la relativité générale, qui veut que tout corps plongé dans l’espace produise un effet d’attraction (principe d’équivalence), et cela vaut aussi bien sûr pour l’antimatière ».

La relativité générale, qui, depuis plus de soixante-dix ans, n’a pas rencontré de contradiction expérimentale, a donné à l’Univers un cadre théorique très cohérent. Il y a peu de chances qu’elle soit contredite. De ce côté-là, c’est donc l’impasse… même si quelques astrophysiciens francs-tireurs n’ont pas perdu espoir.

Parallèlement à cette théorie de l’existence de deux antimondes séparés, Andreï Sakharov émit, en 1967, une hypothèse qui s’intégrait parfaitement au modèle du big bang : grâce aux fluctuations d’énergie (mécanisme décrit plus haut), le vide a engendré autant de matière que d’antimatière, mais c’est pendant le refroidissement et l’expansion de l’Univers que la nature a opté pour la matière. L’antimatière n’y existe donc plus. Sakharov expliquait ce « choix arbitraire » de la nature par ce qu’il a appelé la « brisure de la symétrie ». Et nous voilà revenus au problème de symétrie !

Les physiciens disposent en effet d’un très beau théorème mathématique qui permet de garder leur hypothèse dans le droit chemin de la science. D’après celui-ci, toute théorie physique doit respecter certains principes, notamment ne pas engendrer de contresens logique du type « la conséquence précède la cause ». Ainsi, une théorie qui aurait pour conséquence qu’une pièce soit éclairée avant que la lumière soit réellement allumée serait immédiatement écartée.

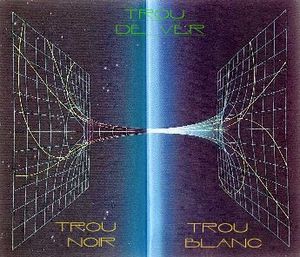

Ce théorème fut démontré dans les années 40. Sous son appellation quelque peu barbare de « théorème CPT » se cache un concept simple : un événement à l’échelle des particules peut se produire dans la nature si l’événement opposé peut également survenir avec la même probabilité. En d’autres termes, les équations doivent rester valables si on remplace la charge de la particule par sa charge opposée (C), si on inverse la distribution spatiale (P) – comme si on regardait la particule dans un miroir -, si on inverse enfin le déroulement du temps (T), c’est-à-dire si on change le paramètre t en – t.

Un exemple plus concret : si l’on provoque un choc violent entre un proton et un électron, on obtient un neutron et un neutrino. Imaginons qu’on filme cet événement. On le projette ensuite en sens inverse (symétrie T), on le regarde dans un miroir (symétrie P) en ayant au préalable « trafiqué » la pellicule afin d’inverser les charges des particules (symétrie C). Cette nouvelle version du film montrerait un antineutron et un antineutrino se heurtant pour donner naissance à un antiproton et à un antiélectron. Si cet événement-là se produit dans un accélérateur de particules avec la même fréquence que le premier, alors la théorie est cohérente.

Mais un risque de contresens surgit lorsqu’on s’évertue à interpréter le théorème CPT. Le fait de changer t en – t (symétrie T) veut-il dire que les particules remontent le temps ? La symétrie P signifie-t-elle qu’elle existe une anti-Terre qui serait l’image de la Terre donnée par un miroir, peuplée d’antihumains en majorité gauchers ? Le théorème laisserait-il présager qu’un vaisseau spatial utilisant de l’antimatière en guise de carburant pourrait, comme dans la série Star Trek, remonter le temps ou dépasser la vitesse de la lumière ? C’est là que la science-fiction se substitue à la science pure.

Toujours est-il que les scientifiques ont rencontré les pires difficultés avec leur théorème CPT. Bien que la symétrie CPT ne soit pas remise en question, cela n’implique pas que C, P et T soient isolément symétriques. De fait, il n’en est rien ! Un beau puzzle peut être formé de morceaux disgracieux. En 1956, l’expérience de trois chercheurs de l’université de Columbia (Caroline du Sud), Lee, Yang et Wu, montra que la symétrie P pouvait être dans certains cas violée. Ils mirent en évidence que, dans la désintégration du cobalt, les particules émises ont une préférence pour certaines directions spatiales. Bref, la nature distingue la droite de la gauche !

D’autres expériences menées sur des « kaons neutres » (particules fort rares, réclamant de très fortes énergies pour être créées dans les accélérateurs) prouvèrent que la symétrie C était aussi violée. Enfin, en 1964, deux chercheurs américains, James Cronin et Val Fitch, et un chercheur français, René Turlay, montrèrent que ces mêmes kaons neutres violaient également la symétrie CP (ce qui valut à Cronin et à Fitch le prix Nobel de physique en 1980 – Turlay ayant été jugé trop jeune pour une telle distinction).

Ces travaux permirent à Sakharov d’émettre l’hypothèse en accord avec le modèle du big bang : si la symétrie CP pouvait être violée en laboratoire, pourquoi ne pas supposer qu’elle aurait pu l’être dans le mégalaboratoire des origines de l’Univers ? Surtout si cette théorie permettait d’expliquer pourquoi la nature avait préféré la matière à l’antimatière ! Depuis l’intuition du savant soviétique (par ailleurs prix Nobel de la paix 1975), l’idée a fait son chemin et s’est parée des beaux habits de la cohérence.

Voici donc le scénario complet : au tout début de l’Univers, au moment de la grande explosion, le vide engendre un fort rayonnement de photons. Ces photons – qui sont leurs propres antiparticules – possèdent une énergie si élevée (1019 GeV) qu’ils peuvent facilement se décomposer en deux bosons opposés, X et anti X. Là est la grande trouvaille. Les bosons sont des particules qui matérialisent les forces de la nature (électromagnétique, faible, forte et de gravitation). C’est la théorie de grande unification (GUT) : plus on remonte dans le temps près du big bang, plus les quatre forces s’unissent pour n’en faire qu’une.

Au moment qui nous intéresse, entre 10-35 et 10-30 seconde, il n’existe que deux forces : la force gravitationnelle et la force unifiée électro-faible-forte. Comme chaque photon se décompose en un X et un anti-X, il y a exactement autant de matière que d’antimatière : la symétrie demeure. Les bosons X et anti-X, porteurs de la triple force unifiée, donnent naissance à de la matière (quarks et électrons) et à de l’antimatière (antiquarks et antiélectrons), dans une proportion légèrement plus forte pour la matière. Ils violent ainsi la symétrie CP. Mais, à cette température (plus de 1028 degrés), la réaction est réversible : la matière et l’antimatière se condensent à nouveau en bosons X et anti-X, recréant la symétrie.

Mais, nouveau problème, la température se met à décroître très vite du fait de l’expansion de l’Univers. Vers 10-30 seconde, elle n’est plus que de 3.1027 degrés. Les bosons X et anti-X peuvent se décomposer en matière et antimatière, mais celles-ci ne peuvent plus se recomposer en bosons et anti-bosons. Or, comme les X et les anti-X ont une prédilection pour la matière, la symétrie est irrévocablement brisée… A peine 1 particule de plus pour 1 milliard de couples particule-antiparticule. Mais ce milliardième de matière supplémentaire suffira à engendrer l’Univers actuel, galaxies, étoiles, planètes, êtres vivants.

Les hommes aiment se raconter des histoires qui finissent bien. Ce scénario, en harmonie avec le big bang, est pour l’instant le plus vraisemblable. Cependant, rien ne dit qu’un autre synopsis ne viendra pas le reléguer un jour au rang des contes de fées scientifiques. En attendant, les astrophysiciens ont recouvré le sommeil.

III – Du carburant pour visiter les étoiles

Et si on explorait les étoiles ? Aujourd’hui, c’est impossible. Demain, pourquoi pas, avec le seul « carburant » que la science nous propose : l’antimatière. Quelques ingénieurs en rêvent déjà…

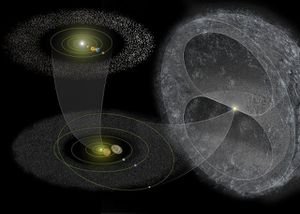

Aussi incroyable que cela paraisse, la navette spatiale américaine pourrait atteindre Proxima du Centaure, l’étoile la plus proche du Soleil (4,3 années-lumière), en moins de dix ans. Ses réacteurs lui procurant une accélération de 1,7 fois l’attraction terrestre, il suffirait de la faire fonctionner à plein régime pendant un peu plus de deux mois. A un détail près : en dehors des problèmes de fiabilité du matériel, le simple poids de carburant nécessaire à un tel exploit la clouerait au sol, qu’elle n’arriverait jamais à quitter…

Et ce n’est pas le seul obstacle : pour atteindre Proxima du Centaure en moins de dix ans, on doit se propulser à une vitesse moyenne proche de la moitié de celle de la lumière (150.000 km/s). On se heurte alors aux lois relativistes d’Albert Einstein. Celles-ci n’imposent pas seulement une vitesse limite à toute chose dans l’Univers, mais alourdissent la masse de tout engin flirtant avec ces records. Ce qui signifie qu’on doit injecter encore plus d’énergie dans les réacteurs, à mesure qu’on veut gagner ne serait-ce qu’un petit supplément de vitesse. Par exemple, alors qu’on file aux trois quarts des fatidiques 300.000 km/s, la masse augmente de 50%. A ce stade, accroître la puissance de la poussée n’apporte presque plus rien.

Fission ou fusion ?

Ces limitations obligent le concepteur à maintenir au strict minimum le poids de départ du vaisseau spatial. Pour donner un ordre d’idée, propulser le plus petit vaisseau habité jusqu’au tiers de la vitesse de la lumière réclamerait la puissance produite pendant plusieurs années par toutes les centrales électriques terrestres ! On peut bien sûr imaginer des plans de science-fiction de longue durée, comprenant la construction de centrales énergétiques spatiales, d’usines en orbite, de mines sur des astéroïdes, sans oublier les stations spatiales destinées au logement des mineurs.

On pourrait plus raisonnablement songer à la propulsion nucléaire électrique, par laquelle on obtiendrait, pour le même poids embarqué, 10 millions de fois plus de puissance qu’avec les carburants classiques. Fondée sur la fission – à l’œuvre dans les premières bombes atomiques –, cette technique soulève cependant quelques problèmes. La fission doit tout d’abord être contenue dans le volume d’un réacteur approprié… qui fondrait aux températures nécessaires à la propulsion. De plus, elle produit des ions lourds, qui se meuvent lentement et n’autorisent donc pas d’accélérations rapides.

En théorie, la fusion est plus adéquate. Une simple boulette de combustible bombardée par des rayons lasers produirait la réaction de fusion dans une chambre de combustion, libérant suffisamment d’énergie pour atteindre de hautes vitesses. Inutile de dire que pas mal d’ingénieurs doutent que la chose soit faisable.

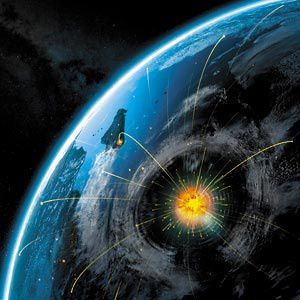

Pour toutes ces raisons, certains ingénieurs voient dans l’antimatière la bonne réponse. Malgré sa connotation de « science-fiction », celle-ci est bien connue des physiciens. Aucune réaction connue ne dégage plus d’énergie que la collision matière-antimatière : elle produit des quantités phénoménales de rayons γ et de mésons π. Ce sont ces derniers qui intéressent les concepteurs de réacteurs. Théoriquement, cette réaction libère de 100 à 1000 fois plus d’énergie que la fusion ou la fission. Ce qui signifie qu’un réacteur à antimatière accélérerait une masse de 1 tonne jusqu’à un dixième de la vitesse de la lumière avec seulement 9 kg de carburant !

Neuf milliards d’années pour fabriquer le carburant

La première difficulté consiste à fabriquer ces 9 kg d’antimatière. Imaginons qu’on utilise le célèbre accélérateur du CERN de Genève, celui qui a récemment créé les antiatomes. Il produit environ 1 milliard d’antiprotons toutes les dix minutes. Ils sont si rapides et si énergétiques qu’ils passent à travers toutes les cibles qu’on met sur leur chemin. Il est donc nécessaire les ralentir si l’on veut conserver un espoir de les capter. Par exemple en plaçant sur leur parcours des feuilles de métal. Ils entrent alors en collision avec les électrons de la matière et perdent progressivement leur énergie. Il faut ensuite les confiner dans un champ magnétique, avant qu’ils rencontrent des protons du voisinage. Si tout va bien, il en restera un bon million, qui pourront être capturés. Mais il en faut beaucoup plus pour fabriquer du carburant : avec environ 1 milliard de milliards d’antiprotons, on en obtient 1 gramme… Comme le piège magnétique est parfaitement fiable, on peut imaginer d’attendre le temps nécessaire pour en obtenir suffisamment. Mais un nouveau problème surgit : le piège magnétique commence à brûler quand une centaine de milliards d’antiprotons se sont accumulés. La force électrostatique par laquelle ils se repoussent mutuellement leur fait frôler dangereusement les parois du piège. Il faut donc employer d’énormes aimants supraconducteurs et beaucoup d’énergie pour les maintenir confinés.

Une autre solution consiste à utiliser des antiatomes, parfaitement neutres, en fabriquant, par un procédé presque similaire, des anti-électrons (positons), et en les faisant orbiter autour des antiprotons après les avoir ralentis. Les deux antiparticules produisent des moments magnétiques qui, contrariés par un champ correctement orienté, engendrent une force qui repousse tous les anti-atomes vers le centre du piège, évitant le choc catastrophique avec les parois. On obtient de l’anti-hydrogène, qu’on peut, en le réfrigérant, condenser en gouttes ou en cristaux. Ce qui permettrait même de se passer de piège magnétique.

Mais, en supposant les problèmes de stockage résolus, et en investissant des sommes colossales dans des usines à antimatière, il faudrait, au rythme très optimiste de 1 millionième de gramme par an, environ neuf milliards d’années pour obtenir les 9 kg requis de carburant ! Les étoiles nous attendront-elles ?

Alors, science-fiction ? Tout n’est pas perdu. En l’état actuel de la technologie, une solution consisterait à utiliser une propulsion qui ne soit pas fondée uniquement sur l’antimatière « pure ». Il est concevable d’utiliser celle-ci comme une sorte de catalyseur des réactions de fission ou de fusion, qu’on peut amorcer avec une simple « boulette » d’uranium. Pour éviter de tout faire sauter, on fabrique de petites capsules d’uranium dans lesquelles on intègre un cœur de deutérium et de tritium. On bombarde ensuite d’antiprotons. Quand un antiproton frappe un atome d’uranium, il s’annihile avec l’un des protons du noyau. Les quelques pions alors émis achèvent de désintégrer le noyau, ce qui libère d’énormes quantités de neutrons, six fois plus qu’une fission nucléaire classique. La réaction en chaîne qui en résulte crée assez de chaleur et de pression pour enclencher une fusion dans le cœur de deutérium-tritium.

Chaque micro-explosion produit autant d’énergie qu’une bombe de 15 tonnes de TNT. Si l’on provoque une par seconde pendant plusieurs jours, on atteindra Pluton en trois ans. Beaucoup d’ingénieur, dont certains de la NASA, ne croient pas une seconde à cette chimère. D’abord parce que la propulsion d’une fusée obéit au principe d’action-réaction. Par quelque bout qu’on prenne le problème, il faut rejeter de la masse par l’arrière si l’on veut aller de l’avant. Il faut donc charger la fusée d’une masse gigantesque. Ensuite, il faut employer des tuyères capables de résister à d’énormes températures. Or, tous les métaux connus, même les alliages les plus sophistiqués et les plus chers, fondent irrémédiablement. Car ces réactions produisent beaucoup de rayons gamma, les plus énergétiques, donc les « plus » chauds.

La route des étoiles est-elle pour autant fermée ? Quels que soient les problèmes techniques, dans le rapport énergie dégagée-poids embarqué, l’antimatière est sans concurrence. L’enjeu vaut qu’on y réfléchisse encore.

/image%2F0564938%2F20221102%2Fob_6bdf5e_foret-028.jpg)

/image%2F0564938%2F20221102%2Fob_3cf8fb_foret-027.jpg)

/image%2F0564938%2F20221102%2Fob_016825_foret-018.jpg)

/image%2F0564938%2F20221102%2Fob_d109a7_foret-024.jpg)

/image%2F0564938%2F20221102%2Fob_7fc474_foret-005.jpg)

/image%2F0564938%2F20221102%2Fob_9a8ed1_foret-014.jpg)

/image%2F0564938%2F20221102%2Fob_66763d_foret-025.jpg)

/image%2F0564938%2F20210514%2Fob_2d5ee6_woman-robot-10.jpg)

/image%2F0564938%2F20210514%2Fob_bcf6c8_woman-robot-02.jpg)

/image%2F0564938%2F20210514%2Fob_fe5f4b_robot-01.jpg)