Ils veulent changer l’espèce humaine

Des hommes transformés génétiquement, plus beaux, plus grands, plus forts, jamais malades… Ce rêve – si dangereux – est aujourd’hui à la portée de généticiens fascinés par la puissance des technologies qu’ils ont élaborées. Qui pourra les arrêter ?

Après la souris et la tomate, voici venir l’homme transgénique. Un projet fou qui vise à introduire de nouveaux gènes dans notre espèce, comme le fait déjà chez les animaux de laboratoire et les plantes. Rien à voir avec les thérapies géniques, comme celles que soutien le Téléthon : elles se bornent à ajouter des gènes dans certaines cellules, mais surtout pas dans les cellules sexuelles, ovocytes ou spermatozoïdes, car la modification se transmettrait de génération en génération avec des conséquences imprévisibles.

En dépit de toutes les mises en garde, et contre l’avis des comités d’éthique du monde entier, des généticiens, de plus en plus nombreux, la plupart américains, envisagent de s’attaquer précisément à ces cellules germinales pour créer des lignées d’hommes transgéniques. Le tabou est brisé.

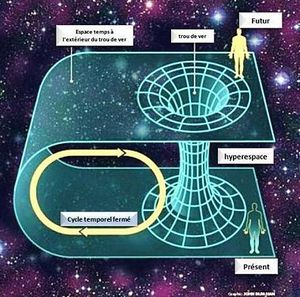

Verra-t-on apparaître une caste de surhommes, dotés de gènes décuplant leur puissance intellectuelle, leur force physique, leur résistance aux maladies, au stress, des hommes capables de vivre plus vieux tout en restant jeunes ? Ils seront nécessairement issus des classes les plus favorisées puisque toutes ces améliorations coûteront fort cher. Dans une divagation futuriste, le biologiste Lee Silver, de l’université de Princeton (New Jersey), auteur de Remaking Eden, imagine la séparation de l’humanité en deux classes, les « GenRich » et les « Natural », évidemment dominée par les premiers. Deux classes qui finissent par constituer deux espèces car elles ne peuvent plus se reproduire entre elles. Vision d’horreur ? Certes, mais Lee Silver est un homme positif : ce serait juste une étape difficile vers l’adaptation de certaines espèces humaines à une vie heureuse sur d’autres planètes.

Revenons sur Terre, en 1990. Des médecins de Bethesda (Maryland) tentent de soigner un enfant atteint d’un grave déficit immunitaire héréditaire en introduisant un gène sain dans ses globules blancs. C’est la première expérience humaine de thérapie génique. A l’époque, le risque de voir le « gène-médicament » contaminer les cellules sexuelles terrifie les autorités médicales. Ce n’est qu’à la condition expresse que cela ne se produira pas qu’on autorise les essais sur l’homme. Mais ce qu’on perçoit toujours comme le danger absolu devient un avantage potentiel aux yeux d’une minorité de chercheurs. Ils espèrent qu’en modifiant les cellules sexuelles ils pourront guérir beaucoup plus facilement les maladies génétiques des enfants qui en seront issus. Ils espèrent même éradiquer ces maladies souvent incurables…

L’an dernier encore, il était fort mal vu d’avance cette idée, quand s’est tenu le premier symposium scientifique consacré à ce qu’on appelle les thérapies génétiques germinales. Organisé par des responsables de l’université de Californie Los Angeles (UCLA), il rassemblait le gratin de la génétique américaine. Les débats avaient pour objet d’examiner l’intérêt des interventions sur les cellules germinales humaines et de fournir une information scientifique de qualité aux autorités de santé qui devront prendre des décisions dans ce domaine.

Pour Grégory Stock, professeur à l’école de médecine de UCLA et co-organisateur du symposium, « la vraie question n’est plus de savoir s’il faut ou non appliquer les thérapies germinales à l’homme, mais quand cela sera possible et comment on s’y prendra. La technologie avance très vite, et ses possibilités sont fascinantes. Elle devrait être disponible dans moins de vingt ans. » Grégory Stock et cons collaborateur John Campbell sont d’intarissables partisans des thérapies germinales, dont ils font la promotion à longueur de congrès et sur leur site Internet. Dans ses conférences, Stock ne cesse de procéder à ce sondage éclair : « Imaginez que vous êtes en train de concevoir un enfant in vitro. Accepteriez-vous, si l’opération est sans danger, qu’on ajoute à l’embryon un gène qui le protégerait du cancer ? » Invariablement, la grande majorité de ses auditeurs répond oui.

Principal argument des défenseurs de cette méthode : elle devrait être beaucoup plus efficace que les thérapies géniques classiques, « Hormis quelques cas anecdotiques, aucune thérapie génique n’a encore fait ses preuves contre une quelconque maladie », rappelle French Anderson (université de Californie du Sud), pionnier mondial dans ce domaine. Ce qui n’a rien de surprenant car « nos organismes ont passé des dizaines de milliers d’années à apprendre à protéger leur génome des gènes étrangers, ceux des virus notamment ». Si plusieurs essais sont prometteurs, note Anderson, les obstacles sont nombreux. En effet, les gènes thérapeutiques, généralement « emballés » dans un virus vecteur inoffensif, ont un long parcours à effectuer avant d’atteindre le tissu cible – par exemple, le muscle dans le cas de la myopathie. Ils traversent les muqueuses (bouche, estomac, poumons) et leur puissant système de défense cellulaire, le système immunitaire, les diverses barrières tissulaires entre les organes, la membrane des cellules cibles, enfin la membrane du noyau cellulaire. Au terme de ce périple semé d’embûches, bien peu de gènes parviennent au but, même quand on vise des tissus plus accessibles tels que la muqueuse des poumons.

Un argument économique

Au contraire, si le gène est intégré dans un œuf fécondé, au premier stade de son développement, il sera présent dans toutes les cellules de l’enfant, dont celles qui fabriquent les spermatozoïdes ou les ovules. Ses descendants bénéficieront donc eux aussi du gène-médicament.

Les thérapies géniques classiques rencontrent un autre écueil, presque insurmontable aujourd’hui : le gène transféré se place un peu n’importe où dans les chromosomes de la cellule hôte, ce qui risque de perturber gravement son fonctionnement. De plus, quand ce gène est mal placé, la cellule aura du mal à l’utiliser et il perdra son efficacité. L’idéal serait d’obtenir une « recombinaison homologue », c’est-à-dire l’insertion du gène thérapeutique en lieu et place du gène déficient. Malheureusement, ce phénomène ne se produit qu’une fois sur dix mille, ou cent mille dans le pire des cas, et nul ne voit encore comment augmenter sa fréquence in vivo.

In vitro, il en va tout autrement. Dans une culture de cellules, la recombinaison homologue reste rare, mais un système de sélection chimique permet d’extraire celles qui ont accompli cette recombinaison avec succès. Justement, la thérapie germinale travaille in viro sur des cultures de cellules embryonnaires. A cet argument technique, les généticiens en ajoutent un autre, économique celui-là : le rapport coût-efficacité des thérapies germinales est nettement plus favorable.

Pour mener à bien leur projet, les généticiens peuvent choisir entre deux méthodes : remplacer les gènes défectueux ou ajouter de nouveaux gènes à l’aide de chromosomes artificiels. Ce sont des chromosomes apparemment comme les autres, à ceci près qu’on les fabrique de toutes pièces en laboratoire, à partir de morceaux d’ADN humain. En théorie, les chromosomes artificiels présentent un avantage majeur : ils dispensent d’insérer les gènes thérapeutiques dans les chromosomes du receveur. Ils viennent simplement se placer à côté des autres dans le noyau des cellules. De plus, leur taille est suffisante pour apporter d’un coup à la cellule un complexe de plusieurs gènes. Le projet le plus futuriste en la matière conçoit le chromosome artificiel comme une sorte de système d’amarrage muni de « bornes » auxquelles on pourrait attacher, à chaque génération, de nouveaux gènes, comme on ajoute des extensions à un ordinateur. On pourrait plus tard remplacer ces gènes-là par de nouvelles versions plus performantes.

Est-ce un délire de savants fous exaltés par leurs rêves de toute-puissance, ou une projection réaliste des applications de techniques déjà disponibles ? Ni l’un ni l’autre. La technologie n’est pas au point, c’est certain. Mais, en dix ans, la génétique a fait des progrès considérables, le décryptage du génome et la découverte des fonctions des gènes avancent à pas de géant, ainsi que la connaissance des enzymes qui participent à leur régulation.

« Si nous avons tendance à surestimer ce que nous serons capables de faire dans cinq ans, estime Mario Capecchi, inventeur des techniques de manipulation génétique les plus élaborées, nous sous-estimons généralement ce que nous pourrons faire dans vingt ans. Aucun obstacle théorique ne s’oppose aux thérapies germinales. »

La France interdit expressément

Désormais, on ne peut plus éviter de s’interroger sur l’avènement des thérapies germinales. Certains pays, dont la France, ont expressément interdit les recherches dans cette voie, mais il n’en va pas de même partout. Si la Déclaration universelle sur le génome humain condamne clairement le clonage et la modification de la nature humaine, elle n’a pas pour autant force de loi.

L’Etat américain ne condamne pas expressément les recherches de ce type, mais tout essai clinique doit être soumis à l’autorisation de la Food and Drug Administration (FDA). Les tenants des thérapies germinales se livrent donc à une entreprise de « lobbying » auprès de cette autorité. S’ils parviennent à faire triompher leur point de vue – certains experts de la FDA n’y sont pas hostiles -, il ne fait aucun doute que ces thérapies trouveront sans mal une clientèle fermement décidée à faire bénéficier sa descendance des progrès de la science.

Le moratoire sur le clonage réclamé par le président Bill Clinton suscite des sentiments mitigés chez les partisans des interventions sur la lignée germinale, car cette technique pourrait être utile à l’aboutissement de leurs travaux. « Il est urgent de ne pas légiférer sur ces questions, estime le prix Nobel James Watson, codécouvreur de l’ADN. Ce serait se priver de moyens thérapeutiques très efficaces. Car on peut discuter sans fin de grands principes, ce que les gens veulent, c’est ne plus être malades. Si nous les y aidons, ils seront d’accord avec nous. » Selon Watson, il sera toujours temps de légiférer si l’on découvre un mauvais usage. Mais, avant qu’on applique cette stratégie à l’homme, elle devra démontrer sa totale innocuité, vérifiée par de nombreux tests sur l’animal.

Eugénisme ou progrès ?

Mus par leur pragmatisme yankee, nos apprentis sorciers pèsent-ils bien les risques qu’ils feraient courir à l’espèce humaine ? Qu’adviendra-t-il des futures générations ? Le généticien français Axel Kahn, membre du Comité consultatif national d’éthique, rappelle que des gènes jugés mauvais aujourd’hui –ceux du diabète, par exemple – ont probablement été bénéfiques dans le passé : ils ont favorisé la naissance de gros bébés. D’autres gènes de prédisposition à certaines maladies pourraient devenir salvateurs un jour, sans qu’on puisse prédire lesquels.

« Si on avait les moyens de l’empêcher, rétorque Lee Silver, qui accepterait de laisser ses descendants souffrir de gènes délétères sous prétexte qu’ils pourront se révéler utiles dans un hypothétique et lointain avenir ? Au nom de quel caractère sacré de l’ADN, n’aurait-on pas le droit d’y toucher ? L’ordre naturel n’est pas forcément bon. Il est simplement le fruit du hasard des changements de l’environnement. Les grandes extinctions du crétacé ont favorisé les mammifères, mais la nature a également fabriqué des virus mortels, et nul ne se plaint que l’homme ait éradiqué celui de la variole. Dès lors, pourquoi ne pas modifier une lignée, si cela peut éviter à des hommes de souffrir ? »

« Je ne comprends pas ceux qui veulent interdire les interventions germinales, renchérit le biologiste Daniel Koshland, ancien directeur de la revue américaine Science. On le fait déjà, puisque, en donnant de l’insuline à un enfant diabétique, on lui permet de vivre et de parvenir à l’âge de la reproduction. Ses enfants seront porteurs des gènes du diabète, ce qui accroît la fréquence naturelle de ces gènes dans la population. » Dans cette logique, il serait donc bénéfique d’intervenir sur la lignée germinale. Cet eugénisme positif et indolore passerait pour un progrès de la médecine. Et puis, cherchent à nous rassurer les généticiens, ces manipulations ne concerneront qu’un nombre limité d’individus puisqu’on ne peut y procéder que lors d’une fécondation in vitro, mode de reproduction qui ne risque pas de se généraliser (environ 8000 naissances par an en France).

Cependant, un point d’éthique tracasse nos démiurges du génome : comment obtenir le « consentement éclairé » des générations futures qu’impose la loi ? Si cette exigence continue à freiner les avancées de la recherche, Mario Capecchi propose deux solutions : d’une part, rendre les modifications génétiques réversibles en retirant les gènes ajoutés ; d’autre part, soumettre l’expression de ces gènes à l’absorption d’un médicament déclencheur.

Où est la barrière morale ?

En y regardant de plus près, la volonté farouche de corriger la lignée germinale apparaît d’autant plus malsaine qu’elle n’est pas nécessaire. Axel Kahn est catégorique : cette méthode ne présente aucun avantage sur la sélection génétique in vitro des embryons avant leur implantation dans l’utérus de la mère. En effet, pour dépister certaines maladies héréditaires incurables, on sait prélever, après une fécondation in vitro, une cellule de l’embryon et diagnostiquer la présence de nombreux gènes anormaux. On élimine ensuite les embryons qui seront malades et on implante seulement ceux qui échapperont à la maladie. Cependant, dans le cas d’une maladie récessive, on n’écartera pas les embryons porteurs sains. Les gènes anormaux se transmettront à la descendance et se manifesteront lorsqu’ils seront de nouveau appariés à des gènes semblables provenant d’une autre lignée.

En France, on considère que la suppression des embryons porteurs sains est un acte eugéniste condamnable. Encore une fois, cette position n’est pas universelle. Mais, si la sélection d’embryons peut suffire, pourquoi vouloir à tout prix manipuler la lignée germinale ? « Parce que ces chercheurs ont un projet autre que thérapeutique, s’écrie Axel Kahn. Ils veulent améliorer des lignées humaines. Sur le plan éthique, c’est inacceptable. » Inacceptable dans de nombreux pays européens traumatisé par les horreurs du nazisme, mais pas forcément en Chine, par exemple.

« Si on a les moyens d’améliorer les hommes, pourquoi ne le ferait-on pas ? » lance James Watson, toujours plus provocateur. Alors que certains tenants de la thérapie germinale s’interrogent sur les limites qu’il faudrait assigner à leurs interventions – rechercher non pas l’amélioration mais seulement la thérapie -, d’autres enjambent la barrière éthique sans vergogne, en faisant remarquer qu’il est d’ailleurs bien difficile de savoir où elle se trouve. A partir de quelque taille un enfant sera-t-il trop petit pour vivre heureux ? Ajouter un gène qui protège du cancer, est-ce une amélioration ou une thérapie préventive ? L’histoire des comités de bioéthique montre bien que, sous la pression de la compétition scientifique et économique, les barrières morales reculent sans cesse. Par exemple, la loi française de 1994 interdit toute recherche sur l’embryon humain, mais déjà le comité national d’éthique propose d’assouplir cette disposition lors de la révision de la loi cette année.

Admettons que les outils soient enfin disponibles, fiables et sans danger. On nous proposera d’abord de les utiliser contre les maladies héréditaires incurables, puis on passera aux maladies engendrées par des prédispositions génétiques, aux affections dues au vieillissement, au cancer, etc. Et pourquoi ne pas y ajouter des gènes de résistance à des virus, ou d’autres qui accroissent la longévité ou améliorent les performances intellectuelles ou physiques ? Nous voici donc en route vers la fabrication de lignées de surhommes aux caractéristiques génétiques artificielles. Domineront-ils le monde ? Seront-ils condamnés à remplir des tâches spécifiques en fonction de leurs aptitudes génétiques ? Ou, comme l’imagine Lee Silver, seront-ils destinés à coloniser des mondes nouveaux ?

Il est inquiétant d’observer que la volonté de créer une espèce humaine améliorée est celle de scientifiques renommés – satisfaisant le désir d’une partie, minoritaire mais déterminée, de la population. En effet, les partisans des thérapies germinales s’accordent avec leurs opposants pour souligner que la demande viendra des couples eux-mêmes.

Dans son Meilleur des mondes, Aldous Huxley n’avait finalement pas prévu le pire. Il était inutile d’imaginer une sorte d’Etat totalitaire qui contrôlerait la reproduction et la nature humaine. Au fil des générations, les individus risquent de s’en charger eux-mêmes en concevant leurs enfants à façon, pour leur donner, en toute bonne conscience, les gènes les plus favorables à leur réussite.

L’homme devient son créateur

Depuis longtemps déjà, par la culture, la technique, la médecine, l’homme échappe à la sélection naturelle. Les thérapies germinales apparaissent comme l’inévitable prolongement de la prise de pouvoir de l’homme sur sa propre évolution. Il devient son propre créateur. Un très vieux rêve, vertigineux, si difficile à refouler. Nos arrière-arrière-petits-enfants sauront-ils renoncer à l’extraordinaire puissance des outils que nous leur forgeons ? Il est déjà trop tard…

La toute puissance des cellules « ES »

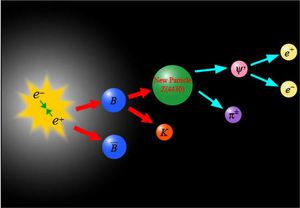

Chez la souris et quelques autres mammifères, on connaissait des cellules embryonnaires douées de capacités extraordinaires : elles se multiplient indéfiniment in vitro sans jamais donner un tissu particulier. Mais, dès lors qu’on les implante dans un embryon, elles peuvent engendrer n’importe quel type de cellule de l’organisme.

Les cellules ES (embryonic stem cells, « cellules souches embryonnaires ») permettent actuellement de concevoir des animaux transgéniques. Les biologistes américains James Thomson et Jeffrey Jones viennent de découvrir le même type de cellules chez l’embryon humain. Ce qui ouvre de fantastiques possibilités pour la production de tissus biologiques ou, dans un avenir plus lointain, pour la conception d’un homme transgénique. Notons que Thomson et Jones ne pouvaient être financés par l’Etat américain, qui se refuse par éthique à soutenir des recherches non thérapeutiques sur l’embryon humain. C’est donc grâce à des crédits privés qu’ils ont mené leurs travaux.

Ils veulent cloner l’homme

Depuis la naissance de la brebis Dolly, en 1997, la plupart des grands pays ont juré qu’on ne fabriquerait pas de clones humains. Cette louable intention empêchera-t-elle de succomber à la tentation de se reproduire eux-mêmes les gens assez riches et assez inconscients pour en avoir envie ? C’est d’autant moins probable que quelques chercheurs indisciplinés sont bien décidés à passer outre. Pour la science, pour la gloire, pour l’argent…

Ecartons le physicien américain William Seed qui clame haut et fort sa volonté de se faire cloner, personne ne le prend au sérieux. Mais le très médiatique obstétricien italien Severino Antinori – à qui l’on doit déjà l’enfantement de femmes de plus de 60 ans et qui aimerait bien être le premier à créer un clone – est très fortuné er pourrait acquérir le savoir-faire de son rêve. On citera également Michel Revel, généticien à l’Institut Weizmann, en Israël : ce religieux pratiquant se déclare favorable au clonage pour lutter contre la stérilité.

Il faut aussi tenir compte des nombreuses cliniques américaines qui ne voient aucun obstacles, sinon technique, à pratiquer le bouturage humaine. Tout récemment, la société Advanced Cell Technology a déclaré avoir créé, par clonage, des embryons homme-vache, ce qui pourrait constituer une étape sur le chemin du clonage humain à partir de cellules embryonnaires.

Cette situation réjouit les partisans de l’homme transgénique, car, pour modifier l’espèce humaine, il pourrait être nécessaire de recourir au clonage.

Petit lexique de génétique

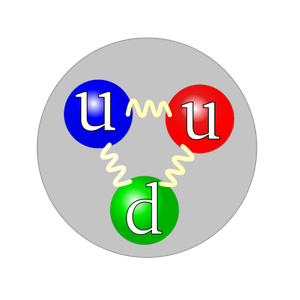

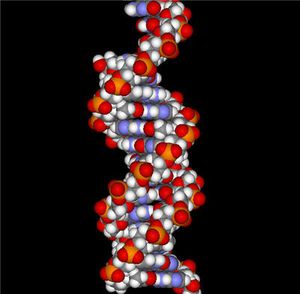

Tous les organismes vivants sont constitués de cellules spécifiques de chaque tissu. Dans leur noyau, elles contiennent une grande molécule, l’ADN (acide désoxyribonucléique), qui, replié sur lui-même et fractionné en longs fragments, forme les chromosomes. L’ADN se compose d’une sorte d’armature en forme de double hélice (comme l’escalier de Léonard de Vinci, à Chambord). Sur chaque brin de l’armature sont fixés les nucléotides : thymine (T), adénine (A), cytosine (C) et guanine (G). L’enchaînement de ces bases est assimilable à un texte dont certaines phrases constituent des informations appelées gènes. On nomme génome l’ensemble des gènes portés par les chromosomes. A partir de cette information, la cellule synthétise des protéines dont elle se sert pour son propre fonctionnement ou qu’elle sécrète à l’usage d’autres cellules.

Toutes les cellules contiennent tous les gènes d’un organisme, mais elles n’utilisent que certains d’entre eux en fonction du tissu auquel elles appartiennent. En effet, selon les tissus, les cellules contiennent diverses molécules nommées facteurs de transcription qui n’activent que certains gènes, par exemple, celui de la synthèse des protéines du lait dans les cellules des glandes mammaires quand une hormone vient déclencher ce processus. On dit d’un organisme qu’il est transgénique quand il a intégré à son génome un gène étranger de sorte que ce gène se transmet à toute sa descendance, créant ainsi une lignée transgénique.